Das Agenten-Missverständnis: Dem Taschenrechner das Denken beibringen

Stell dir vor, du hast einen hochmodernen Snackautomaten gebaut. Er nimmt Geld an, zeigt Optionen an, gibt Snacks aus und wechselt sogar Geld. Und jetzt stell dir vor, du nennst diesen Automaten „intelligent", weil du ihn so programmiert hast, dass er „Vielen Dank für Ihren Einkauf!" mit einer fröhlichen, von einem KI-Modell generierten Stimme sagt.

Genau das passiert bei vielen Dingen, die heute als „KI-Agenten" bezeichnet werden.

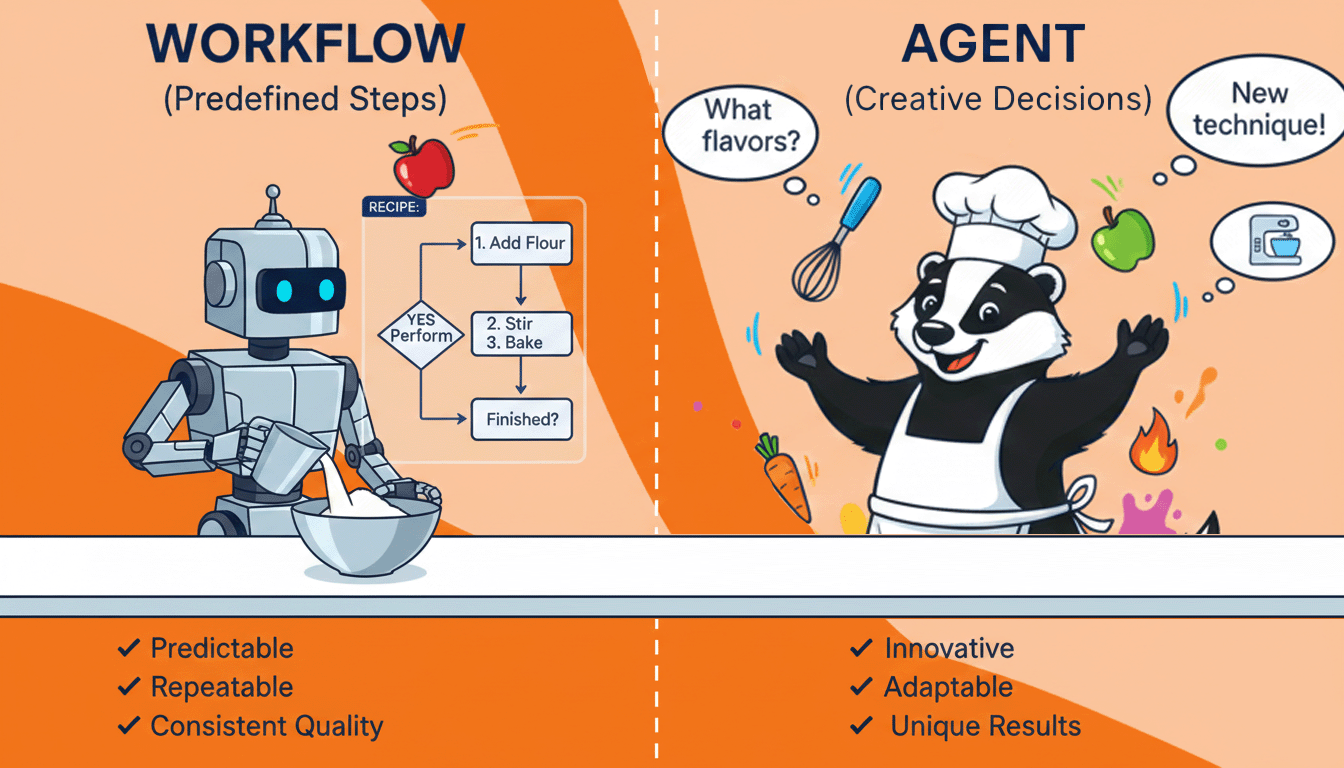

Das Kochbuch-Problem

Fangen wir mit einer Geschichte an. Du lernst kochen und hast zwei Helfer:

Helfer A folgt dem Rezept deiner Großmutter exakt. Auf der Karte steht: „Wenn die Soße zu dick aussieht, einen Esslöffel Wasser hinzufügen. Wenn sie zu dünn ist, 5 Minuten länger köcheln lassen." Helfer A kann diese Anweisungen perfekt ausführen und nutzt sogar eine KI, um zu beurteilen, ob die Soße „dick aussieht". Beeindruckend? Sicher. Aber wenn die Soße anbrennt, weil dein Herd zu heiß ist, wird Helfer A weiter dem Rezept folgen, während die Küche sich mit Rauch füllt.

Helfer B versteht das Kochen. Sie wissen, warum die Soße eindickt, wie Anbrennen riecht und wie man Hitze, Timing und Zutaten spontan anpasst. Sie könnten sogar entscheiden, von vorne anzufangen, wenn etwas schiefgeht. Du gibst ihnen ein Ziel – „mach eine gute Pastasoße" – und sie finden den Weg.

Die meisten „KI-Agenten" sind heute Helfer A mit einem sehr schicken Rezept.

Was macht etwas wirklich zu einem Agenten?

Denk mal darüber nach, was du tust, wenn du bei der Arbeit auf ein unbekanntes Problem stößt. Du führst nicht einfach ein vorher festgelegtes Skript aus. Du:

- Bewertest die Situation in Echtzeit und bemerkst Dinge, die nicht im ursprünglichen Plan standen

- Triffst Entscheidungen, welchen Ansatz du zuerst versuchst

- Merkst, wenn du feststeckst und probierst etwas anderes

- Überprüfst deine Arbeit und fängst deine eigenen Fehler ab

- Bittest um Hilfe, wenn du wirklich nicht weiterkommst

Das ist Handlungsfähigkeit. Es ist der Unterschied zwischen dem Befolgen von Anweisungen und dem Navigieren zu einem Ziel.

Der Chatbot, der es nicht konnte

Hier ist ein konkretes Beispiel, das den Unterschied verdeutlicht. Ein Unternehmen baute einen „Kundenservice-Agenten", der:

- Kundennachrichten mit einem LLM analysieren konnte

- Prüfte, ob Schlüsselwörter zu bestimmten Kategorien passten

- Relevante Hilfeartikel aus einer Datenbank abrief

- Eine freundliche Antwort generierte, die diese Artikel einbezog

In Tests funktionierte es wunderbar. Dann wurde es live geschaltet.

Ein Kunde schrieb: „Ich versuche seit drei Tagen, mein Abonnement zu kündigen. Eure Kündigungsseite zeigt einen Fehler an, euer E-Mail-Support hat nicht geantwortet, und ich bin kurz davor, die Lastschrift bei meiner Bank zu widerrufen."

Der „Agent" erkannte Schlüsselwörter: „kündigen", „Abonnement", „Fehler". Er holte den Hilfeartikel mit dem Titel „So kündigen Sie Ihr Abonnement", generierte eine höfliche Nachricht, die die Kündigungsschritte erklärte, und schickte sie ab.

Der Kunde war verständlicherweise wütend.

Ein echter Agent hätte erkannt: Diese Person hat den normalen Weg bereits versucht. Der normale Weg ist kaputt. Das erfordert eine andere Art von Hilfe. Er hätte an einen Menschen eskalieren, den Systemstatus prüfen, eine direkte Kündigung anbieten oder zumindest die defekte Erfahrung anerkennen können.

Aber das System war nicht dafür konzipiert, über Kontext nachzudenken – nur um ein Skript auszuführen, das Muster mit Antworten abglich.

Die drei Illusionen von Handlungsfähigkeit

Illusion 1: „Es nutzt KI, also ist es intelligent"

Einen LLM-Aufruf in deinen Code einzubetten, macht deinen Code nicht intelligent – genauso wenig wie die Verwendung eines Taschenrechners deine Tabellenkalkulation zu einem Mathematiker macht. Das LLM ist ein Werkzeug – ein bemerkenswert gutes für bestimmte Aufgaben – aber ein Werkzeug aufzurufen bedeutet nicht, Entscheidungen zu treffen.

Illusion 2: „Es kann verschiedene Eingaben verarbeiten"

Deine Mikrowelle kann verschiedene Garzeiten verarbeiten. Das ist keine Intelligenz, das ist Parametrisierung. Echte Agenten verarbeiten nicht nur verschiedene Eingaben für denselben Prozess – sie wählen verschiedene Prozesse basierend auf der Situation.

Illusion 3: „Es verkettet mehrere Schritte"

Komplexität ist keine Handlungsfähigkeit. Eine Rube-Goldberg-Maschine hat viele Schritte, aber null Fähigkeit zur Anpassung, wenn Schritt 7 nicht wie erwartet funktioniert. Viele „Agenten-Frameworks" sind einfach Rube-Goldberg-Maschinen mit LLMs an den Verbindungsstellen.

Wie echte Handlungsfähigkeit aussieht

Denk an einen Recherche-Assistenten – einen menschlichen. Du bittest ihn, „herauszufinden, warum das neue Produkt unseres Konkurrenten bessere Bewertungen bekommt als unseres."

Er folgt keinem Skript. Er könnte:

- Damit beginnen, aktuelle Bewertungen beider Produkte zu lesen

- Bemerken, dass Rezensenten eine bestimmte Funktion erwähnen

- Beschließen, die technische Umsetzung dieser Funktion zu untersuchen

- Erkennen, dass ihm die nötige Fachkompetenz fehlt

- Ein Gespräch mit eurem Engineering-Team vereinbaren

- Herausfinden, dass das eigentliche Problem die Reaktionszeit des Kundensupports ist

- Seine gesamte Recherche-Richtung ändern

Bei jedem Schritt beobachtet, entscheidet und passt er sich an. Er trägt die Verantwortung für das Ziel, nicht nur für die Aufgabe.

Ein KI-Agent mit echter Handlungsfähigkeit würde ähnlich arbeiten: ständig bewerten, ob der aktuelle Ansatz funktioniert, bereit sein, zurückzugehen, erkennen können, wann er überfordert ist, und kreativ genug sein, um Ansätze zu versuchen, die du nicht explizit programmiert hast.

Das Kochbuch vs. der Koch

Hier ist das mentale Modell, das hilft:

Ein skriptbasiertes System ist ein Kochbuch. Selbst wenn jedes Rezept KI verwendet, um zu prüfen, ob das Essen fertig ist, folgt es nur Rezepten. Du willst Chocolate-Chip-Cookies? Schlag Seite 47 auf. Das Kochbuch wird nicht beschließen, stattdessen Brownies zu machen, weil es bemerkt hat, dass dir die Schokoladenstückchen ausgegangen sind, du aber jede Menge Kakaopulver hast.

Ein Agent ist ein Koch. Du sagst ihm: „Ich brauche ein Dessert für acht Personen, jemand ist allergisch gegen Nüsse, und ich brauche es in 90 Minuten." Er wird herausfinden, was er macht, sich an das anpassen, was in der Vorratskammer ist, während des Kochens probieren und Fehler korrigieren, bevor er serviert.

Warum diese Unterscheidung wichtig ist

Das zu verstehen ist nicht nur semantische Haarspalterei. Es prägt, wie du baust, wie du testest und was du deinem System zutrauen kannst.

Wenn du ein ausgeklügeltes Skript gebaut hast, ist das wirklich nützlich! Skripte sind vorhersehbar, debuggbar und oft genau das, was du brauchst. Erwarte nur nicht, dass sie mit Situationen umgehen können, die du nicht vorhergesehen hast.

Wenn du versuchst, echte Agenten zu bauen, musst du für Folgendes entwerfen:

- Beobachtung: Der Agent muss die Ergebnisse seiner Handlungen und den aktuellen Zustand wahrnehmen können

- Entscheidungsfindung: Echte Wahl zwischen verschiedenen Strategien, nicht nur Parameterauswahl

- Selbstbewertung: Die Fähigkeit, Misserfolg und Erfolg zu erkennen

- Wiederherstellung: Mechanismen, um verschiedene Ansätze auszuprobieren, wenn man feststeckt

Eine bessere Frage

Anstatt zu fragen „Ist das ein Agent?" – was oft in Definitionen und Gatekeeping ausartet – frag:

„Wenn ich diesem System ein Ziel gebe, das es noch nie gesehen hat, könnte es bedeutende Fortschritte machen, ohne dass ich Code umschreibe?"

Wenn die Antwort nein ist, hast du Automatisierung gebaut. Wertvolle, nützliche Automatisierung, aber eben Automatisierung.

Wenn die Antwort ja ist, kommst du irgendwo Interessantem hin.

Die Zukunft von KI-Systemen besteht nicht darin, alles „agentisch" zu machen. Es geht darum, gezielt vorzugehen: intelligente Automatisierung zu verwenden, wo Vorhersehbarkeit wichtig ist, und echte Handlungsfähigkeit, wo Anpassungsfähigkeit die Komplexität und Kosten wert ist.

Den Unterschied zu verstehen ist nicht nur technisch – es geht darum, Systeme zu bauen, die tatsächlich die Probleme lösen, die wir gelöst haben wollen, statt beeindruckende Demos, die unter realer Unordnung zusammenbrechen.